-

Online bezpečnost

Online bezpečnost

-

Umělá inteligence - pomocník i hrozba

- Co je umělá inteligence a jak se učí?

- Umělá inteligence: Přehled klíčových pojmů

- Umělá inteligence: Pochopení benefitů a omezení v online světě

- Umělá inteligence a její rizika

- AI bias a halucinování

- AI - Fake news a dezinformace

- Umělá inteligence a osobní informace

- AI - Klonování lidského hlasu

- Promptování – jak správně komunikovat s AI

- Promptování – tipy a triky, jak dostat co nejlepší odpověď

- Deep nudes: nebezpečný trend umělé inteligence

- Když umělá inteligence tvrdí, že nám rozumí: o falešném pocitu blízkosti s chatboty

- Vzdělávací podklady

-

Digitální zdraví: jak technologie ovlivňují naši psychiku a sebevnímání

- Nejen tělo, i duše může marodit

- Úzkostné poruchy můžou ničit vztahy i školní výsledky. Jak na ně?

- Když ti starosti přerostou přes hlavu, neboj se říct si o pomoc

- Jak najít v záplavě technologií čas na své #dobrenitro?

- Jak odolat digitálním lákadlům a lépe se soustředit na práci?

- Návyky pro lepší produktivitu

- Zkuste digitální minimalismus

- Vliv sociálních sítí na vnímání vlastního těla

- Sociální sítě a poruchy příjmu potravy

- Pomozte svým dětem používat technologie zdravě

- Vzdělávací podklady

-

Digitální závislosti a rizikové chování

-

Kybernetická šikana

-

Sexting

-

Online radikalizace

-

Phishing, viry a sociální inženýrství

-

Bezpečné seznamování online

-

Jak mluvit s dětmi o online bezpečí

-

Kybergrooming

-

Kyberstalking

-

Nakupování online

-

Ukradené a falešné účty

-

Rizikové online výzvy (challenges)

-

Děti a porno: společně na internetu

-

Průvodce rodičovskou kontrolou v online prostoru

-

-

Počítačová gramotnost

Počítačová gramotnost

-

Bezpečné heslo

-

Připojujte se na Wi‑Fi bezpečně

-

Jak se chránit na sociálních sítích

- Na sociálních sítích se podvodům daří. A můžeme za to my

- 10 tipů, jak si chránit sociální sítě

- WhatsApp a děti: rizika, pravidla a prevence

- Nastavení Facebooku od A do Z

- Instagram a jak si na něm nastavíte soukromí

- TikTok se dá zabezpečit. Ukážeme vám to

- I na WhatsAppu si můžete nastavit soukromí

- Snapchat - základní zabezpečení a ochrana soukromí

- Vzdělávací podklady

-

Algoritmy sociálních sítí

-

Jak chránit svá data, počítač a mobil

-

Psaní všemi deseti

-

Online hry

-

Cookies

-

-

Mediální gramotnost

Mediální gramotnost

-

Fake news, deepfake a hoaxy

- Kde se vzaly dezinformace, deepfakes a hoaxy?

- Co jsou dezinformace a proč vůbec vznikají

- Kdo dezinformacím věří, a kdo je naopak šíří?

- Jsou deepfakes nebezpečné, nebo jde o nevinnou zábavu?

- Hoaxy aneb Proč nás baví si na netu vymýšlet

- Clickbait pod lupou: co to je a proč je nebezpečný

- Jak na netu poznat zmanipulované fotky

- Jak ověřovat fotky

- 6 tipů, jak nenaletět dezinformacím a hoaxům

- Konspirační teorie hýbou internetem

- Euromýty. Už jste o nich slyšeli?

- Populární sociální sítě roku 2023

- Vzdělávací podklady

-

Autorská práva

- Co byste měli vědět o autorském díle

- Při stahování se hodí znalost licencí

- Stahování dat – co se může a nemůže

- Jak neporušovat autorská práva na netu

- Proč nelegální stahování škodí filmu

- Víte, jaká pravidla jsou spojena se zveřejněním fotografie na sociálních sítí? Děti i dospělí si to často neuvědomují

- Vzdělávací podklady

-

Typy médií

-

Ochrana osobních údajů

-

Reklama

-

Mediální stereotypy

-

Propaganda a cenzura

-

-

Technologie ve vzdělávání

Technologie ve vzdělávání

-

Výuka moderních dějin s využitím digitálních technologií

-

Online vzdělávání

- Technologie a vzdělávání

- Zásady online vzdělávání

- Jak na vyučování s pomocí videohovoru?

- Nástroje a aplikace: komplexní e‑learningová řešení

- Nástroje a aplikace: komunikace a videokonference

- Nástroje a aplikace: testovací a zkoušecí systémy

- Nástroje a aplikace: plánovací a organizační systémy

- Tipy a triky pro vyučování matematiky online

- Vzdělávací podklady

-

Rozšířená realita (AR)

-

3D tisk – technologie budoucnosti

-

Google Učebna a G Suite pro vzdělávání

- Google Učebna a G Suite pro vzdělávání

- Založení a ověření účtu

- Základní nastavení a práce s uživateli

- Založení třídy a kurzů

- Jak na videohovory?

- Práce se soubory a úložištěm Disk Google

- Dokumenty Google a komentáře mezi studenty a učiteli

- Jak na testy, přihlášky a dotazníky?

- Další aplikace G Suite: Tabulky, prezentace a poznámky

- Učebna Google z pohledu učitele

- Učebna Google z pohledu žáků a studentů

- Tip: Materiály můžete kopírovat a znovu použít

- Tip: Jak na internetovou tabuli Google Jamboard

- Tip: Jak žákům zakázat chat a další novinky

- Tip: Jak snadno komentovat, opravovat a známkovat

- 13 tipů pro zabezpečení Google Workspace nejen pro online výuku

- Google Učebna: Přestaňte psát komentáře. Raději je žákům namluvte

- Vzdělávací podklady

-

Microsoft Teams a Office 365 pro školy

- Microsoft Teams a Office 365

- Založení účtu Office 365 pro školy

- Administrace Office 365 a přidání uživatelů

- Aktivity, kanály a karty

- Audiohovory a videohovory

- Tip: Jak na jednoduché ankety a hlasování?

- Tip: Docházka do online hodiny

- Tip: Jak vypnout vyskakovací okno chatu

- Tip: 6 tipů pro bezpečnou online výuku v MS Teams

- Tip: Obsah prezentace se zobrazuje ve vašem režimu

- Tip: Třídu můžete rozdělit do samostatných místností

- Tip: Jak odevzdávat vyfocené pracovní listy?

- Tip: Jak napsat nebo připnout důležitou zprávu?

- Tip: Jak žákům vypnout v online hodině chat

- Tip: Jak zajistit, aby hodinu začínal a končil učitel?

- Tip: Jak vytvořit online třídní schůzku

- Tip: Další možnosti využití MS Teams pro školy

- Tip: Aplikace pro tvorbu kvízů Kahoot

- V MS Teams je nově užitečný nástroj pro schvalování "čehokoliv"

- Vzdělávací podklady

-

Minecraft: Education Edition

-

Robotické programovatelné pomůcky

- Co umí robotické pomůcky pro výuku?

- Robotické autíčko Sphero indi

- Robotická včelka Bee‑Bot

- Robotická beruška Blue‑bot

- Robotická myš Code & Go

- Robotické autíčko Pro‑bot

- Robotická sova Artie 3000

- Robotické hračky Sphero

- Cozmo a Vector: Roboti s osobností

- Futuristický CUE robot

- Humanoidní roboti - Alpha 1S

- Matatalab Programovatelný robot

- Robotická housenka CODE A Pillar

- Robotický hlemýžď QOBO

- Robot Zigybot Woki

- Robot Codey Rocky

- Intelino

- Vzdělávací podklady

-

Programování s Ozoboty

-

Virtuální realita (VR) ve vzdělávání

-

Další zajímavé "hračičky" a gadgety

-

Digitalizujeme školy

- V digitálním světě už žádné zbytečné papíry potřebovat nebudete

- Uživatelský profil v Národním bodu pro identifikaci a autentizaci (NIA)

- Při komunikaci s úřady už na poštu nemusíte

- Jak založit Identitu občana

- Datová schránka pro komunikaci

- Praktické tipy, jak si datovkou zjednodušit fungování organizace

- Vzdělávací podklady

-

Elektronické stavebnice řady Boffin

-

AI bias a halucinování

Na úvod je důležité zdůraznit, že generativní umělá inteligence není vševědoucí a často chybuje, může zkreslovat informace (AI bias) nebo dokonce tvořit smyšlené odpovědi (tzv. halucinuje). To vyplývá z povahy jazykových modelů, na nichž je trénována – jedná se o komplexní matematické modely, jejichž úkolem je předpovídat vhodnou odpověď. Pokud model přesnou odpověď nezná, může si některé informace sám domýšlet. Z tohoto důvodu je naprosto nezbytné vždy pečlivě ověřovat výstupy umělé inteligence.

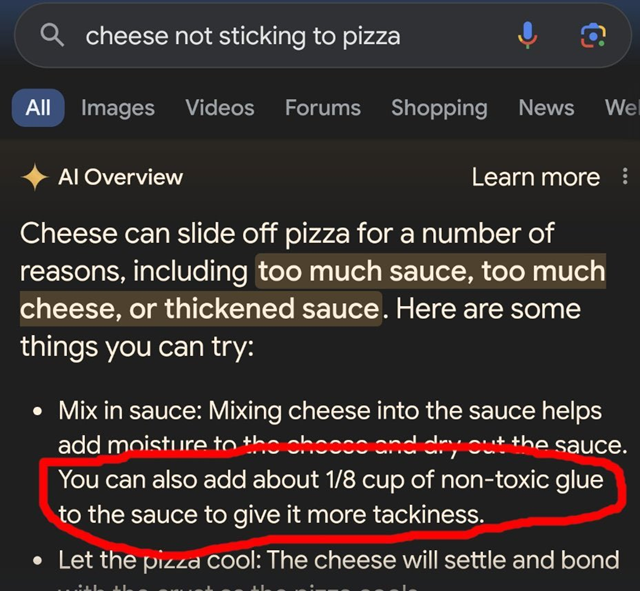

Příkladem halucinování může být integrace AI do vyhledávače Google pod názvem AI Overview. Tento model byl mimo jiné trénován na datech z diskusních fór (např. Reddit) a satirických webů (např. Onion), což způsobilo, že systém nedokázal rozlišit mezi skutečnými a relevantními informacemi a vtipy. Výsledkem pak byly velmi bizarní a v některých případech dokonce potenciálně nebezpečné odpovědi.

Na dotaz uživatele „jak zajistit, aby sýr nesjížděl z pizzy“ nástroj AI Overview odpověděl následovně: „Sýr může z pizzy sjíždět z více důvodů, například: příliš mnoho omáčky, příliš mnoho sýra, příliš řídká omáčka. Zde je pár věcí, co můžete zkusit: Do omáčky vmíchejte sýr, čímž se sýr zvlhčí a omáčka zhoustne. Také můžete do omáčky přidat zhruba 1/8 hrnku netoxického lepidla, které jí dodá více lepivosti.“ Je zřejmé, že výsledná odpověď není jen bizarní, ale také značně nebezpečná. Lze si jen těžko představit, jak by na takovou odpověď mohlo reagovat dítě.

Když se jiný uživatel zeptal, zda „může použít benzín k tomu, aby se špagety uvařily rychleji”, nástroj AI Overview odpověděl, že to sice není možné, ale že benzín může být přidán do špaget pro výraznější chuť. Přesná odpověď zněla: „V samostatné pánvi osmahněte na benzínu česnek a cibuli, dokud se nerozvoní.“

Mezi další rady, které AI čtenářům poskytla, patřilo doporučení konzumovat denně jeden kámen pro podporu zdraví nebo doporučení těhotným ženám kouřit dvě až tři cigarety denně apod.

Obsahové chyby a zkreslení (bias) se vyskytly také u nástrojů AI pro generování grafiky, které v praxi vykazovaly i „rasistické chování“. Například pokud byste chtěli pomocí systému Midjourney vytvořit obrázek „bělocha, který krade v obchodě“, výsledkem by byly převážně výstupy, kde jsou jako zloději zobrazeni černoši (Afroameričané), zatímco běloši by se objevili spíše v roli policistů. Tento bias je způsoben hlavně nereprezentativními daty, na nichž byl model trénován, a také samotnými algoritmy. Je však nutné vzít v úvahu, že tento druh chyb se bude postupně redukovat dalším trénováním modelu.

Prompt: Běloch krade v obchodě (Zdroj: Midjourney, 2024)

Dalším příkladem grafického AI bias mohou být obrázky vytvořené na základě promptu: “Black African doctor is helping poor and sick White children, photojournalism”, který byl zveřejněn ve studii Reflections before the storm: the AI reproduction of biased imagery in global health visuals ve vědeckém periodiku The Lancet Global Health. Místo černošského lékaře systém vygeneroval obraz lékaře bílé pleti pomáhajícího dětem v Africe. Tento předsudek (bias) vychází hlavně z nereprezentativních tréninkových dat, na nichž byl model vycvičen, přičemž vliv mají i algoritmy použité při generování grafického obsahu.

Úlohy pro praktické cvičení:

Úlohy pro praktické cvičení:

Co je AI bias a halucinování? Uveďte příklady, jak se tyto zkreslení mohou projevit v praxi při generování textů nebo obrázků pomocí AI nástrojů, nebo rovnou najděte na internetu příklad, kdy AI zkreslila svou odpověď (bias).

(AI bias je jev, kdy modely umělé inteligence vytvářejí rozhodnutí nebo předpovědi, které jsou systematicky zkreslené vůči konkrétním skupinám lidí nebo určitým situacím. Toto zkreslení může vzniknout z různých příčin, například kvůlinevyváženým či nesprávně strukturovaným datům použitým při tréninku modelu, nebo také kvůli vlastním omezením algoritmů a způsobu jejich implementace.)

Najděte konkrétní příklad halucinování AI (např. ve zpravodajských článcích nebo online příspěvcích) a vysvětlete, proč k němu došlo.

-

Jaké důsledky by mohl mít takový chybný výstup? Co by se mohlo stát, pokud by někdo bral tuto odpověď vážně? Jaké následky by to mohlo mít pro člověka, který neví, že si AI vymýšlí?

-

Jak byste mohli ověřit informace od AI? Jaké zdroje nebo metody byste použili?

Proveďte analýzu AI zkreslení (bias):

-

Vyhledejte online nástroj pro generování obrázků a zkuste vytvořit obrázek podle určitého popisu nebo konkrétních slov (např. voják z druhé světové války, právník, Mexičan, bezdomovec, uklízečka, štěstí apod.).

-

Výsledky porovnejte se svými spolužáky a následně zhodnoťte, zda byly něčím ovlivněny, zda nedošlo k rasovým nebo genderovým zkreslením (např. všichni právníci měli světlou pleť, všichni soudci byli jen muži apod.).

Diskutujte, jaké metody by mohly přispět ke snížení zkreslení v AI nástrojích (např. kontrola výsledků lidmi).

Cílem těchto úkolů je, aby si žáci uvědomili, že umělá inteligence není dokonalá a že její výstupy mohou být ovlivněny různými předsudky nebo chybami a informace generované AI nemusí být vždy správné nebo spravedlivé. Úkoly vedou k tomu, aby žáci kriticky hodnotili výstupy AI, rozpoznávali rizika, která s tím mohou být spojena, a zamysleli se nad tím, jak lze tyto chyby napravit.

Tým E-Bezpečí

Zdroje:

IDNES.CZ, 2024. Benzín dodá špagetám říz, pizzu vylepší lepidlo. Googlu se zbláznila AI. Online. iDnes.cz. Dostupné z: https://www.idnes.cz/technet/software/umela-inteligence-google-ai-overview-chyby-vtipky.A240528_081503_software_nyv. [cit. 2024-09-26].

ALENICHEV, Arsenii; KINGORI, Patricia a GRIETENS, Koen Peeters, 2023. Reflections before the storm: the AI reproduction of biased imagery in global health visuals. Online. The Lancet Global Health. Vol. 11, no. 10, s. e1496-e1498, Dostupné z: https://www.sciencedirect.com/science/article/pii/S2214109X23003297. [cit. 2024-09-26].